Il professor Silvano Tagliagambe, è professore emerito di filosofia della scienza all’Università di Sassari ed è stato titolare della stessa cattedra all’Università di Cagliari, Pisa e Roma “La Sapienza”. E’ autore di un numero impressionante di studi filosofici e scientifici, pubblicati nei principali e più autorevoli editori reperibili nei principali canali italiani, tra cui ricordiamo, Il sogno di Dostoevskij. Come la mente emerge dal cervello (Raffaello Cortina, 2001), Tempo e sincronicità. Tessere il tempo (Mimesis, 2018), Metamorfosi. Cervello in divenire, benessere psicofisico e nuove strategie terapeutiche, (Mondadori, 2019). Potete anche seguire il professor Tagliagambe nel suo sito personale: http://www.silvanotagliagambe.net/. Egli è anche l’autore della prefazione al libro Anche Kant amava Arancia Meccanica che i lettori di Scuola Filosofica conoscono bene e per la quale gli sarò eternamente grato! A nome del Team di Cultural Promoting Advisor, di Scuola Filosofica, Azione Filosofica, del nostro Eugenio Dessy, e di tutti i nostri numerosi lettori, professor Tagliagambe: grazie!

Inizierei con una domanda introduttiva ma che, in realtà, ha una sua rilevanza filosofica. Cosa l’ha spinta inizialmente a dedicarsi alla filosofia e, in particolare, come è giunto a studiare epistemologia e filosofia della scienza?

Quando stavo per finire il liceo ero incerto se iscrivermi a filosofia o a fisica. Andai all’Università statale di Milano ad ascoltare alcune lezioni di Ludovico Geymonat, che insegnava Filosofia della scienza, sperando che mi aiutassero a prendere una decisione e a scegliere. In effetti fu così. Ricordo che si parlava di Moritz Schlick fisico e filosofo tedesco fondatore del Circolo di Vienna, che Geymonat aveva conosciuto e frequentato nel 1934-35 quando si era recato nella capitale austriaca, e del passaggio, che egli aveva contribuito a operare, dal vecchio positivismo, che aveva ancora una visione metafisica della scienza, al nuovo, che cercava di indagare il significato dei concetti e delle leggi della scienza. Ciò che mi attrasse in quelle lezioni e mi convinse a iscrivermi a filosofia era il progetto di elaborare un razionalismo diverso da quello tradizionale: più aperto, più critico, consapevole che le teorie scientifiche sono modificabili e non rappresentano mai una verità assoluta: un razionalismo consapevole di quella crisi che, agli inizi del ‘ 900, era stata la grande svolta della matematica, nonché la teoria della relatività e la meccanica quantistica in fisica: il venir meno dei fondamenti stabili e permanenti, senza tuttavia smarrire il senso della solidità e del rigore della ricerca scientifica.

Non ho mai creduto che la scienza possa fare a meno della filosofia per la semplice ragione che ogni scienza ha delle assunzioni metafisiche e metodologiche dalle quali non può comunque prescindere. Quale è il suo parere in materia?

Sì è proprio così. Generalmente si pensa che, alla base della scoperta scientifica, vi sia un insieme ben definito e convergente di osservazioni scientifiche che, grazie a un processo di generalizzazione induttiva, porta in maniera quasi automatica alla formulazione di un’ipotesi da sottoporre poi al vaglio della corroborazione o della falsificazione da parte dei risultati degli esperimenti. È stato però Einstein a sottolineare che raramente le cose vanno così: e certamente non sono andate in questo modo nel suo caso. La formulazione, da parte sua, della teoria della relatività generale è infatti un esempio tipico di quella che può essere definita la “mossa del cavallo”, ovvero la tendenza a trasgredire in modo più o meno virtuoso la logica della teoria all’interno della quale si opera. Operazione che, in genere, è supportata da un’idea-intuizione in grado di prefigurare una storia diversa che dà significati differenti agli elementi della realtà dell’oggetto presenti nel racconto-teoria, sino a vestirli, passo dopo passo e in un processo raramente lineare, con nuovi abiti concettuali che, tutti assieme, irrobustiscono il guardaroba del racconto-storia-intuizione iniziale.

In un articolo, titolato “Induzione e deduzione nella fisica”, egli espresse in maniera mirabile nel 1919 sul Berliner Tageblatt questo tipo di procedura. Innanzi tutto, sintetizzò il normale modo di procedere delle scienze empiriche precisando che si basano sul metodo induttivo che dal raggruppamento dei fatti singoli fa emergere con evidenza una relazione che li connette; per poi arrivare a “regolarità più generali, fino a configurare – in considerazione dell’insieme disponibile dei singoli fatti – un sistema più o meno unitario, tale che la mente che guarda le cose a partire dalle generalizzazioni raggiunte per ultime potrebbe, a ritroso, pervenire di nuovo ai singoli fatti particolari”.

Poi, però, Einstein sottolineò anche che “un pur rapido sguardo allo sviluppo effettivo della scienza mostra che i grandi progressi della conoscenza scientifica solo in piccola parte si sono avuti in questo modo. Infatti, se il ricercatore si avvicinasse alle cose senza una qualche idea (Meinung) preconcetta, come potrebbe egli mai afferrare, dal mezzo di una enorme quantità della più complicata esperienza, fatti i quali sono semplicemente sufficienti a rendere palesi relazioni legiformi? Galilei non avrebbe mai potuto trovare la legge della caduta libera dei gravi senza l’idea preconcetta stando alla quale, sebbene i rapporti che noi di fatto troviamo, sono complicati dall’azione della resistenza dell’aria, nondimeno noi consideriamo cadute di gravi nelle quali tale resistenza gioca un ruolo sostanzialmente nullo”.

Insomma, l’induzione sembra valida nella routine o, per un certo periodo, nel procedere consolidato, mentre “i progressi veramente grandi della conoscenza della natura si sono avuti seguendo una via quasi diametralmente opposta a quella dell’induzione. Una concezione intuitiva dell’essenziale di un grosso complesso di cose porta il ricercatore alla proposta di un principio ipotetico o di più principi di tal genere. Dal principio (sistema di assiomi) egli deduce per via puramente logico-deduttiva le conseguenze in maniera più completa possibile. Queste conseguenze estraibili dal principio, spesso attraverso sviluppi e calcoli noiosi, vengono poi messe a confronto con le esperienze e forniscono così un criterio per la giustificazione del principio ammesso”.

Ed è attraverso questo processo che conduce all’unione del principio (assiomi) e delle sue conseguenze, che si ha la formazione della così detta teoria, ma, secondo Einstein, “ogni persona colta sa che i più grandi progressi della conoscenza della natura – per esempio, la teoria della gravitazione di Newton, la termodinamica, la teoria cinetica dei gas, l’elettrodinamica moderna, ecc. – hanno tutti avuto origine per questa via, e che il loro fondamento è di natura ipotetica. Il ricercatore parte dunque sempre dai fatti, il cui nesso costituisce lo scopo dei suoi sforzi. Ma egli non perviene al suo sistema teorico per via metodica, induttiva; egli piuttosto, si avvicina ai fatti tramite una scelta intuitiva tra teorie pensabili basate su assiomi”.

In chiusura dell’articolo, Einstein fa alcune importanti considerazioni di carattere epistemologico generale precisando che “una teoria può ben venir conosciuta come sbagliata, qualora ci sia un errore logico nelle sue deduzioni o può venir riconosciuta come inadeguata (unzutreffende) allorché un fatto non si accordi con una delle sue conseguenze. Ma mai potrà venir dimostrata la verità di una teoria. E ciò perché mai si sa se anche nel futuro non si scoprirà nessuna esperienza che contraddica le sue conseguenze; e sono sempre pensabili altri sistemi di pensiero, in grado di connettere gli stessi fatti dati. Se sono a disposizione due teorie, entrambe compatibili con il materiale fattuale dato, allora non esiste nessun altro criterio per preferire l’una all’altra che lo sguardo intuitivo del ricercatore. È così che si capisce come acuti ricercatori i quali dominano teorie o fatti, possono tuttavia essere appassionati sostenitori di teorie opposte”.

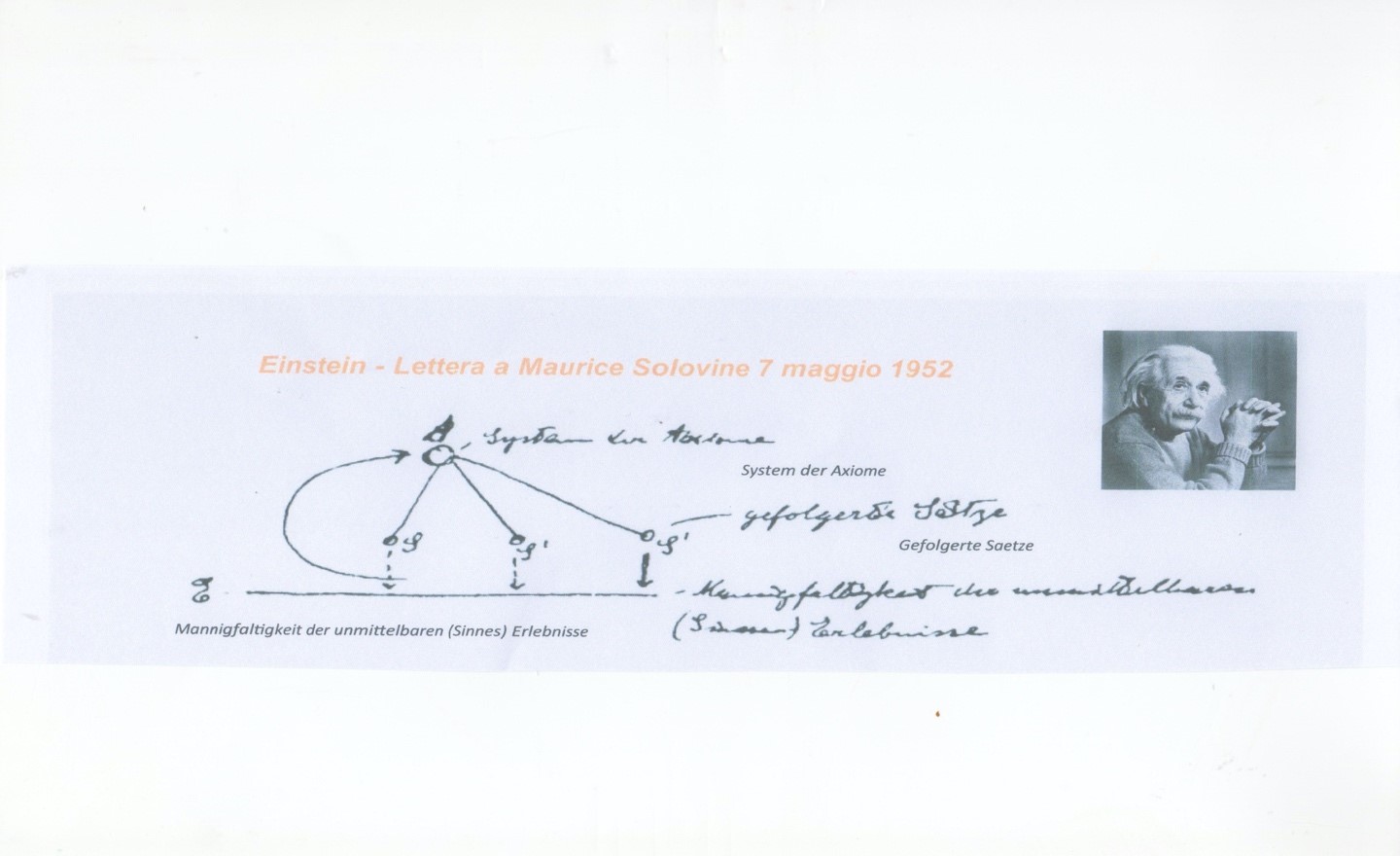

Gli stessi concetti vengono da lui ribaditi in una famosa lettera del 7 maggio 1952 a Maurice Solovine dove, per spiegare il percorso che porta alla formulazione di una nuova teoria scientifica, propone il seguente schema:

I punti che ne emergono possono essere così sintetizzati:

- non esiste alcun percorso logico che dalle E (esperienze immediate) conduca agli assiomi A;

- dagli A si ricavano, con procedimento deduttivo, enunciati particolari S che possono pretendere di essere veri;

- gli S sono messi in relazione con le E (verifica per mezzo dell’esperienza). Questa procedura appartiene essa stessa alla sfera extralogica (intuitiva), non essendo di natura logica la relazione tra i concetti che intervengono negli enunciati e le esperienze immediate;

- l’aspetto essenziale è qui il legame, eternamente problematico, fra il mondo delle idee e ciò che può essere sperimentato (esperienza sensibile).

Dello stesso anno, 1952, è un celebre saggio di Wolfgang Pauli, premio Nobel per la fisica del 1945 per la scoperta del principio di esclusione che porta il suo nome, uno dei cardini della meccanica quantistica, che parla di Keplero e dell’influsso delle immagini archetipiche sulla formazione e lo sviluppo delle sue teorie scientifiche. In esso egli osserva, in totale sintonia con Einstein, che il punto di vista puramente empirico, che vuol far risalire ogni spiegazione a una descrizione basata sui dati empirici (anche se generale e concettuale) non prende in considerazione il fatto che ogni enunciazione di un concetto o di un sistema di concetti (e con ciò anche quella di una legge naturale) è una realtà psichica d’importanza decisiva. L’uomo, a suo giudizio, diviene cosciente di una nuova conoscenza quando riesce a istituire una efficace corrispondenza tra il mondo fisico e l’universo interiore, dando luogo a quella che si presenta, di fatto, come una sovrapposizione d’immagini interiori preesistenti nella psiche umana (quelli che Jung chiama «archetipi», nel caso di Keplero la credenza, appoggiata dall’autorità di molti filosofi, nei privilegi della circolarità, che lo spinse per molto tempo a condividere la convinzione di Brahe secondo la quale i pianeti si muovono in cerchi perfetti) con gli oggetti esterni e il loro comportamento.

Il richiamo a Jung significa un’esplicita condivisione della sua idea della dimensione creativa della percezione, come capacità di inventare una situazione di equilibrio e di stabilità, in grado di tenere insieme le potenzialità, a prima vista incompatibili, di un sistema in stato metastabile.

La chiave per interpretare correttamente questo processo, a giudizio del fondatore della psicologia analitica, sta in una prospettiva policronica che si palesa sotto forma di effetto della continua ibridazione di dimensioni temporali differenti, in particolare di ciò che è unico e irripetibile (la singolarità dell’individuo) con qualcosa di comune e condiviso, radicato nella tradizione culturale del passato, che si manifesta attraverso l’inconscio collettivo e i suoi archetipi, e un processo di sperimentazione continua, attraverso la quale può originarsi e svilupparsi la varietà necessaria per il futuro senza che essa interferisca immediatamente con i processi necessari per il presente. Potremmo così dire che la persona umana si presenta come il modello paradigmatico di un’organizzazione duale, nella quale gli scopi del breve termine e gli scopi del lungo termine, orientati sia verso il passato anche remoto, sia verso il futuro, si integrano in un meccanismo assai complesso, non solo molto efficiente, ma anche molto efficace. Si deve allora concludere che, per i sistemi viventi s’impone la necessità di essere articolati in una triplice dimensione temporale, con un saldo radicamento nel passato, un piede nel presente e un altro nel futuro: bisogna saper far bene il lavoro di routine, consolidando le tendenze ereditate dal patrimonio della storia dell’umanità e quelle in atto, e generando adattamenti a queste tendenze. Ma bisogna altresì sapersi nutrire della consapevolezza che queste tendenze si avvicinano sempre più al punto di rottura e che presto emergeranno altri equilibri caratterizzate da logiche e da regole assai differenti, in ogni caso non riducibili a quelle del momento presente.

Questo processo di continua ricerca e di sperimentazione di equilibri sempre nuovi fa emergere concretamente un’immagine del processo di individuazione nella quale la continuità e le regolarità si basano su vincoli da interpretarsi non come necessità predeterminate e astratte, bensì quali risultati di una storia che è creatrice di nuove forme e che vanno quindi visti non soltanto e non tanto come limiti del possibile, ma anche e soprattutto come condizioni di nuovi possibili.

Da questo punto di vista il processo in questione si presenta come un vero e proprio atto di creazione, l’invenzione continua di una dimensione atta a risolvere un pregresso stato di tensione, il risultato di uno sviluppo che, se ben condotto e svolto, è in grado di garantire sempre nuove e ulteriori strutturazioni, dando luogo alla realizzazione di una parte di quelle possibilità insite nella convergenza tra il piano indeterminato e preindividuale, carico di potenziali, che ciascuno eredita dal passato, anche remoto, sotto forma di archetipi, il presente della sua specifica individualità e l’orientamento progettuale verso il futuro.

Quale è il ruolo della ragione nel mondo contemporaneo? Essa viene attaccata da molteplici fronti, dall’economia alla psicologia, per dimostrare che essa non è onnipotente. Ma d’altra parte, lo è mai stata?

Il problema è come si intende la ragione e quale funzione le si attribuisce. Alla base degli attacchi e delle critiche alle quali essa viene sottoposta vi è un motivo di fondo, evidenziato già quasi un secolo orsono da una delle menti più acute e chiaroveggenti del nostro paese, anche se austriaco di nascita, essendo venuto al mondo nel 1906, col nome di Bruno Johannes Leonhard Maria von Finetti, a Innsbruck, allora capitale della contea del Tirolo, dove il nonno, Giovanni Cavalieri von Finetti, un imprenditore edile di Trieste, si era trasferito per partecipare alla costruzione della ferrovia dell’Arlberg, e cresciuto a Trento, città della stessa contea, dove era nata la madre che vi ritornò poco dopo la morte del marito Gualtiero, che aveva rilevato la società paterna nel 1910 e aveva poi ottenuto l’incarico di direttore di costruzione a Trieste.

Matematico e statistico, universalmente noto per i suoi contributi al Calcolo delle Probabilità, alla Statistica, alla Matematica finanziaria e attuariale, all’Economia e all’Analisi, de Finetti nel 1923, dopo che il Trentino e l’Alto Adige, alla fine della Prima Guerra mondiale, erano passati all’Italia, si iscrisse al Politecnico di Milano e due anni dopo si trasferì al neonato corso di laurea in matematica applicata dell’università del capoluogo lombardo.

Nel 1934, all’età di 28 anni, scrisse un agilissimo e lucidissimo saggio, dal titolo L’Invenzione della Verità, splendido esempio di concezione costruttivista della scienza, un antidoto contro ogni cristallizzazione in “verità assolute” del territorio mobile della conoscenza, nel quale, prendendo atto degli (allora) ancora recenti sviluppi proprio della meccanica quantistica rifletteva sui nuovi obiettivi che la conoscenza doveva assumere.

De Finetti si riferiva, in particolare, alla posizione lucidamente espressa da uno dei padri della teoria quantistica, Wolfgang Pauli, al quale sarebbe stato attribuito 11 anni più tardi, nel 1945, il premio Nobel per la fisica come riconoscimento della scoperta del «principio di esclusione» che porta il suo nome, il quale proprio in quegli anni condannava senza appello il «vecchio tipo di spiegazione della natura», che parte «dal presupposto di un osservatore indipendente» e che, di conseguenza, «assumeva un decorso totalmente determinato dei fenomeni naturali».

In fisica ormai, sottolineava Pauli, il termine «fenomeno» deve essere utilizzato esclusivamente per riferirsi alle osservazioni ottenute in circostanze ben definite, comprendenti una descrizione dell’intero apparato sperimentale scelto dal soggetto conoscente per indagare e misurare i fenomeni e il processo, oggetto della sua analisi. Il fenomeno quantistico non è quindi mai ripetibile in modo identico, è fondamentalmente irreversibile, è una totalità. Un processo atomico diviene un fenomeno solo all’atto dell’osservazione (che è un’azione, espressa dal prodotto di un’energia per un tempo e si misura in unità della costante di Planck, h = 6,6·10-34J·s) ed è inseparabile dalle condizioni scelte. Prima di questo atto abbiamo leggi naturali formulate in termini matematici (in particolare l’equazione d’onda di Schrödinger), la quale governa l’evoluzione di un sistema fisico quantistico, in assenza di una misurazione di grandezze fisiche nel sistema stesso. E, come noto, il problema maggiore della meccanica quantistica è proprio quello di conciliare l’aspetto reversibile dell’evoluzione con quello intrinsecamente irreversibile della misurazione.

L’osservatore, di conseguenza, non ha più la posizione distaccata o nascosta che gli viene implicitamente riconosciuta dalle idealizzazioni dei modelli classici di descrizione; ma con la scelta delle condizioni di osservazione, e a causa degli effetti indeterminati e incontrollabili, egli determina ogni volta una nuova situazione, dà origine in senso letterale a un fenomeno nuovo. Cessa dunque di esistere una «linea di demarcazione netta» tra «ciò che si descrive» e «il modo in cui lo si descrive».

Da questo punto di vista l’elemento di novità della meccanica quantistica è dunque costituito dall’interferenza tra la misurazione dei fenomeni e la perturbazione di questi ultimi indotta dall’operazione di misura. Anche questo aspetto è evidenziato da Pauli con la consueta lucidità e capacità di sintesi: “Gli osservatori o gli strumenti d’osservazione a cui la moderna microfisica deve far riferimento si differenziano in modo essenziale dall’osservatore indipendente della fisica classica. Per osservatore indipendente intendo un osservatore che non è necessariamente privo di un effetto sul sistema osservato, ma la cui influenza può essere eliminata attraverso opportune correzioni. In microfisica, invece, le leggi sono di un tipo tale che ogni incremento di conoscenza guadagnato con una misurazione viene necessariamente pagato con la perdita di altre conoscenze complementari. Ogni osservazione è allora un intervento di entità non esattamente quantificabile sia sul piano osservato che sull’apparato di osservazione, e interrompe la connessione causale tra i fenomeni che la precedono e quelli che la seguono. Questa interazione incontrollabile fra osservatore e sistema osservato che ha luogo in ogni osservazione rende impraticabile la concezione deterministica su cui si fonda la fisica classica. Questo gioco che segue regole predefinite, una volta avvenuta la libera scelta dell’osservatore tra dispositivi sperimentali che si escludono a vicenda, viene interrotto dall’osservazione selettiva; la quale, in quanto evento essenzialmente non automatico, può essere paragonata a un atto di creazione nel microcosmo o anche a una mutazione, ma in ogni modo con un risultato imprevedibile e incontrollabile”.

All’interno della teoria si registrano dunque due differenti modalità di evoluzione del vettore di stato. Da un lato, le normali interazioni tra due sistemi atomici, o tra un sistema atomico e un oggetto macroscopico che non sia un apparato di misura, sono caratterizzate da un’evoluzione deterministica regolata dall’equazione di Schrödinger, che descrive naturalmente anche l’evoluzione dei singoli sistemi che non interagiscono, mentre dall’altra il processo di misura provoca invece una transizione discontinua dallo stato iniziale a uno degli stati finali possibili. L’esistenza di una simile dualità era già stata chiaramente sottolineata fin dal 1932 da von Neumann, che aveva individuato una precisa distinzione tra «misurazioni ed esperimenti discontinui, non causali e agenti istantaneamente» che definì come «willkürliche Veränderungen durch Messungen» (cioè cambiamenti arbitrari attraverso la misurazione) e «cambiamenti continui e causali nel corso del tempo» che chiamò «automatische Veränderungen», cioè cambiamenti automatici. La teoria quantistica senza osservazione non determina più i fenomeni stessi, ma la loro possibilità, la probabilità che succeda qualche cosa.

De Finetti era quindi perfettamente consapevole che, nella meccanica quantistica, per passare da una descrizione impartecipe a una misura attiva occorre rimuovere la stazionarietà e entrare nella dimensione tempo: e da questa consapevolezza trae la conclusione che la scienza non si può affidare alla sola previsione, cioè al semplice desiderio di «sapere come le cose andranno… come se andassero per conto loro!». Si tratta «di un problema di decisione, non di previsione». Questo è il punto: per l’uomo la previsione non è un fine, ma un mezzo, uno strumento per assumere decisioni efficaci, per cui è necessario abbandonare l’idea unidimensionale di «previsione» per passare a quella ben più complessa di «strategia», basata sul ruolo attivo dell’osservatore. A maggior ragione i sistemi socioeconomici, che hanno consapevolezza di sé stessi, non vanno per conto loro. Noi ne siamo interpreti e agenti, per cui ogni politica che li riguardi è condannata inesorabilmente all’inefficacia se non si innesta sulla possibilità e capacità di dare nuova forma e nuovo senso alle forme della costruzione collettiva della cultura e della partecipazione.

Proprio partendo da queste premesse de Finetti non si è voluto limitare a evidenziare gli aspetti costruttivisti della buona scienza, ma si è impegnato con successo a identificare in modo profondo l’aspetto costitutivo dell’incertezza, modellando un rigoroso e originale approccio alla teoria delle probabilità, caratterizzato da una concezione soggettivistica basata sul presupposto che, nei casi di alta complessità, dobbiamo ricorrere, per l’appunto, a una scommessa razionale, a una scelta deliberata dell’osservatore. L’incertezza è la frontiera mobile della conoscenza: non abbiamo altra scelta, dato che la scissione tra l’evoluzione deterministica dei singoli sistemi che non interagiscono, che approda alla loro descrizione, e il passaggio all’azione che rende possibile l’osservazione e la misura, le quali provocano, come detto, una transizione discontinua dallo stato iniziale a uno degli stati finali possibili, ci obbliga a prendere atto di quanto sia infondata la «speranza» di chi ritiene che la probabilità di un evento futuro è tanto maggiore quanto maggiore è la frequenza osservata di eventi «analoghi». Aggiunge però che, mentre è impossibile una giustificazione globale di questa regola, è possibile una sua giustificazione locale, ricorrendo a una nuova ipotesi, estremamente chiara e semplice – l’ipotesi di scambiabilità, individuata proprio da lui.

É interessante e istruttivo accennare almeno al significato di questa ipotesi. Come de Finetti ha più volte ribadito, la posta in gioco, sotto il profilo del valore della scienza, riguarda la giustificazione del «ragionamento induttivo», ossia di quel “ragionamento che precisa il senso e il modo in cui si fanno, ed è giustificato fare, delle previsioni, in termini di probabilità, basandosi sull’esperienza, e precisamente – in particolare – sull’osservazione della frequenza dei successi in un numero (possibilmente grande) di casi “analoghi” a quello (o quelli) di cui ci interessa prevedere il risultato”. Ora, la sua concezione soggettiva mette a disposizione della teoria della probabilità uno strumento efficace per vagliare il modo in cui le probabilità vengono modificate in seguito all’acquisizione di informazioni aggiuntive. Infatti, dalla definizione della probabilità condizionata e dalle usuali leggi di calcolo si ricava il teorema di Bayes, in base al quale la probabilità di un’ipotesi I subordinata a un’evidenza H è proporzionale al prodotto della probabilità di I per la probabilità di H subordinata a I: ovvero questo teorema ci dice che la probabilità di I subordinata a H “si modifica nella stessa direzione e nella stessa misura” della probabilità di H subordinata a I. Come osserva ancora de Finetti: “Per applicare il teorema di Bayes occorre attribuire delle probabilità alle «ipotesi» prese in considerazione, e vedere poi come variano in seguito alle successive osservazioni e informazioni, e in base a ciò trarre le conclusioni. A ciò si oppone la preclusione dogmatica dei frequentisti contro l’attribuzione di una probabilità a un ‘caso singolo’. Quale probabilità si doveva attribuire alla teoria di Wegener (sulla deriva dei continenti) all’epoca in cui i più l’avversavano? E più tardi? Tali questioni, per costoro, sarebbero state prive di senso, a meno di ammettere la possibilità di sperimentare molte ripetizioni della creazione del mondo e vedere in quale percentuale di casi i fatti si sviluppano in accordo con la teoria di Wegener. Invece, l’accumularsi di conoscenze meglio spiegabili con la teoria di Wegener anziché con quella dei suoi oppositori ha portato alla sua pressoché generale accettazione”.

Il teorema di Bayes tuttavia non ci consente di giustificare globalmente l’induttivismo. Anzi, una volta impostato nell’ottica del «soggettivismo» il problema del ragionamento induttivo, “ci sarà impossibile dimostrare la validità del principio di induzione, e cioè del principio secondo cui il valore della probabilità dovrebbe essere vicino alla frequenza osservata”. Soluzioni locali del problema sono però possibili subordinandole “a condizioni soggettive relative alle valutazioni di probabilità, e precisamente occorre che l’analogia tra i vari eventi ci faccia ritenere ugualmente probabile che le prove favorevoli e sfavorevoli si alternino in un ordine piuttosto che in un altro qualsiasi”. Questa, appunto, è la condizione di «scambiabilità». È sufficiente che essa venga accettata perché il ragionamento induttivo “valga in senso stretto”; basta poi “che la nostra opinione non si allontani enormemente da questo caso ideale perché le conclusioni sussistano, almeno qualitativamente, inalterate”, casi estremi a parte.

In questa lucida analisi sono già indicate, ex ante, le ragioni delle attuali difficoltà in cui si trova la ricerca scientifica: di fronte alla mancanza di precedenti storici del coronavirus, che permettano di farlo rientrare all’interno della classe, già studiata con esiti collaudati, delle epidemie e pandemie del passato, viene a mancare il terreno solido su cui si basa usualmente la ricerca scientifica, vale a dire l’evidenza costruita grazie alle regolarità del corso degli eventi e alla possibilità, che ne consegue, di proiettare nel futuro le esperienze del passato. Il principio di induzione vacilla e si dimostra uno strumento poco affidabile per fare delle previsioni, anche in termini di probabilità, facendo riferimento all’osservazione della frequenza dei successi in un numero (possibilmente grande) di casi pregressi.

Ecco perché non si può “lasciar andare” le cose, come se procedessero per conto loro, e bisogna impegnarsi attivamente nella costruzione di nuovi scenari, per lo più inediti, e che esigono, proprio per questo, l’uso di strumenti per pensare differenti da quelli usuali. In particolare all’induzione occorre sostituire un tipo di ragionamento diverso, che proprio perché ci deve servire da sostegno di fronte alla sfida dell’innovazione non può partire dalla classica distinzione, operata dal neopositivismo ed esposta e argomentata in modo rigoroso da Reichenbach, tra il contesto della giustificazione e il contesto della scoperta, per sostenere che la filosofia si può occupare legittimamente solo del primo, che ha a che fare con la verifica e la conferma, mentre il secondo è di pertinenza della piscologia. Egli e altri positivisti logici affermavano quindi che esistono logiche induttive della giustificazione, ma non logiche della scoperta. Sono state proposte logiche induttive della giustificazione sia ipotetico-deduttive sia bayesiane, o comunque probabilistiche; ma, secondo Reichenbach appunto, un esame attento della pratica scientifica reale rivela sempre nuovi argomenti e procedimenti giustificativi che mettono in forse l’adeguatezza di queste logiche.

Norwood Russell Hanson, dal canto suo, ha distinto le ragioni per cui accettiamo un’ipotesi specifica da quelle che ci fanno supporre che l’ipotesi corretta sia di un tipo particolare, e per le seconde ha cercato di elaborare delle logiche del ragionamento retroduttivo o abduttivo che valorizzavano il ragionamento analogico, ma non è riuscito a convincere molti che queste logiche fossero veramente diverse per natura da quelle della giustificazione.

Le posizioni assunte da De Finetti, quasi un secolo fa, ponevano un problema che recentemente è stato ripreso e riproposto in un libro di John Kay e Mervyn King, dal titolo Radical Uncertainty: Decision-Making Beyond the Numbers, uscito all’inizio dello scorso marzo, quindi da poco più di due mesi, che dà pienamente ragione alla visione anticipatrice contenuta nell’opera del 1934 L’invenzione della verità, sottolineando che la maggior parte delle situazioni della vita comporta ormai un’incertezza radicale per la quale i dati storici non forniscono una guida utile ai risultati futuri. L’incertezza radicale non può essere descritta nei termini probabilistici applicabili a un gioco d’azzardo. Non è solo che non sappiamo cosa accadrà. Spesso non sappiamo nemmeno il tipo di cose che potrebbero accadere. Non stiamo quindi parlando dei “cigni neri” identificati da Nassim Taleb (eventi sorprendenti che nessuno avrebbe potuto prevedere fino a quando si verificano), sebbene questi “cigni neri” siano esempi di radicale incertezza. Stiamo enfatizzando, scrivono gli autori, la vasta gamma di possibilità che si trovano tra il mondo di eventi improbabili che possono tuttavia essere descritti con l’aiuto di distribuzioni di probabilità e il mondo dell’inimmaginabile. Questo è un mondo di futuri incerti e conseguenze imprevedibili, su cui vi è la necessaria speculazione e inevitabile disaccordo – disaccordo che è arduo cercare di risolvere. L’analisi che viene proposta è tanto più impressionante se si tiene conto del fatto che Mervyn King è stato dal 2003 al 2013 Governatore della Banca d’Inghilterra mentre John Jay ha insegnato economia all’Università di Oxford, alla London Business School e alla London School of Economics ed è stato per molti anni collaboratore fisso del Financial Times. Per affrontare l’inimmaginabile occorre far ricorso a tutte le risorse di immaginazione e creatività di cui l’uomo dispone: e gli esperimenti mentali, come l’onda a cavalcioni di Einstein, il gatto di Schrödinger, il paradosso di Einstein, Podolsky e Rosen, l’hotel di Hilbert ma anche l’esperimento della doppia fenditura di Feynman che da “mentale” è diventato poi effettivo con l’esperimento, che è stato definito “il più bello del mondo”, fatto per la prima volta negli anni Settanta a Bologna, sono appunto la risposta di scienziati geniali a questa sfida posta dall’incertezza radicale e dall’inimmaginabile. Raggiungere l’obiettivo di superare e “addomesticare” ciò che appare inimmaginabile con la capacità di immaginazione di cui l’uomo dispone è davvero una grande soddisfazione, che può essere assimilata allo sforzo, pienamente riuscito, di piegare la forza di un “demone”. È questa la concezione “allargata” della ragione con la quale ci dobbiamo ormai confrontare e misurare.

Be First to Comment