Scopri Intelligence & Interview di Scuola Filosofica!

Iscriviti alla Newsletter!

Consigliamo Capire la critica della ragion pura

“[L]e tre leggi della Golemica (…): 1) un golem non può nuocere all’uomo né permettere che, per il suo mancato intervento, un uomo riceva danno; 2) un golem deve sempre obbedire agli ordini ricevuti, a meno che questi non contrastino con la Prima Legge; e infine, 3) un golem è tenuto ad autoconservarsi e a difendersi a meno che questo non contrasti con la Prima e Seconda legge.”[1]

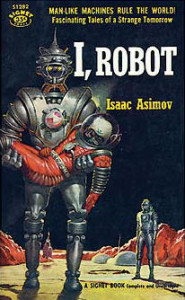

Le cosiddette “tre leggi della robotica”, nel nucleo, non sono proprio un’idea originale di Isaac Asimov, grandissimo scrittore di fantascienza nonché intelligente divulgatore scientifico. I “robot” nella narrativa fantascientifica sono più che un corollario. Surrogati dell’uomo per qualche particolare, come in Philip Dick, dotati di psicologia assolutamente equiparabile a quella umana. Oppure “elaboratori umani privi di sentimenti” come in Asimov. Però, è si avverte, non solo nella letteratura, ma anche nella realtà, l’esigenza di dare delle regole rigide a degli oggetti capaci di comportamenti identici a quelli umani, ma distinti dalla nostra specie.

L’idea di una realtà materiale, meccanica capace di avere comportamenti uguali a quelli umani è un’idea piuttosto vecchia. “Secondo la tradizione ebraica, infatti, il golem (la parola vuol dire letteralmente “materia amorfa”, ciò che un giorno fu anche Adamo) è una creatura d’argilla che, con determinati accorgimenti, può essere portata a vita vegetativa, ma soltanto da un rabbino. A lui obbedirà ed eseguirà gli ordini che gli verranno dati. Per animare un golem basta una semplice combinazione di lettere (…). Sulla fronte dell’uomo artificiale va incisa la parola aemeth, che significa “verità”; ogni venerdì sera si deve cancellare dalla fronte della creatura la sillaba ae, proponendosi di non riscriverla fino alla domenica seguente. Le lettere che rimangono formano la parola meth, cioè “morte”, e rappresentano il comando rivolto al golem di rimanere inerte per tutta la durata del sabato.”[2] Come Lippi osserva, Asimov si pone esattamente lo stesso problema di chi ha immaginato per primo il mitico essere, il terribile, angoscioso, magico, misterioso, stupefacente Golem.

Perché l’uomo dovrebbe creare un Robot nel futuro? Per la stessa ragione per cui la gran parte degli occidentali non vogliono fare i lavori manuali: sono faticosi, rendono poco e sono socialmente umilianti. Oppure possono svolgere dei compiti altamente rischiosi, che non dovrebbero meritare il coinvolgimento o il rischio della perdita di una vita umana: il soldato. Nel primo caso, abbiamo dei Robot-schiavi, assimilabili ai “servi” di Hegel e sono i Robot di Asimov. In questo caso, i Robot potrebbero assumere dei compiti non manuali, pure organizzativi ma che non richiedano, comunque, la presenza di un principio di responsabilità: il Robot deve rimanere un “puro servo”. Nel secondo caso abbiamo, invece, un Robot-soldato, come nel caso degli androidi di Blade Runner. Nel romanzo di Dick non siamo in presenza di Robot irresponsabili ma, guarda caso, la società, dopo averli generati, si pente e cerca in tutti i modi di eliminarli per timore che possano sostituirsi agli esseri umani. Un timore con fondamenti analoghi a quello del razzista.

Il problema fondamentale: possono esistere degli esseri del tutto simili a noi che, tuttavia, non sono come noi. E’ il caso dei cloni, assimilabili agli zombie di Chalmers[3]. Ne abbiamo terrore e l’opinione pubblica viene manipolata dai politicanti che insistono sulla pericolosità della clonazione umana, additando al clone la latente pericolosità di un Hitler o di uomini incapaci di sentire emozioni[4]. Questo senso di terrore, dovuto all’impotenza del riconoscimento del pericolo attraverso qualche segno manifesto ed esteriore, è esattamente ciò che Asimov argina con le tre leggi della Robotica.

Asimov, in realtà, descrive i Robot con tratti fisici distinti da quelli umani: sono chiaramente razionali, premurosi, visibilmente distinguibili dagli uomini (con l’eccezione di R. Daneel e qualche altro caso sporadico).

Le tre leggi della Robotica, in realtà, sono di più di tre, nel senso che esse, scomposte più adeguatamente, indicano i comportamenti che un Robot non può seguire “per principio”:

1) un robot non può nuocere all’uomo né permettere che, per il suo mancato intervento, un uomo riceva danno;

2) un robot deve sempre obbedire agli ordini ricevuti, a meno che questi non contrastino con la Prima Legge;

3) un robot è tenuto ad autoconservarsi e a difendersi a meno che questo non contrasti con la Prima e Seconda legge.

La prima legge ci dice due cose:

a) un robot non può nuocere all’uomo;

b) un robot non può permettere che, per mancato intervento, un uomo riceva danno;

Si può dire che le due proposizioni sono sinonimiche in vista del fine, perché si fondano entrambe sull’idea che il Robot debba procedere sia in senso attivo che passivo sempre e comunque per la salvaguardia della vita dell’uomo. Sono due leggi diverse: da un punto di vista formale, sillogistico, esse implicano inferenze diverse, in secondo luogo pongono praticamente dei comportamenti diversi. Se per “legge” vogliamo intendere “ciò che spiega un comportamento all’interno di una teoria” dobbiamo per forza interpretare la prima legge come due leggi distinte volte a chiarificare uno stesso fine. Lo stesso fine, non giustifica l’identità.

La prima legge vincola il Robot ad agire sempre verso un fine non contrario alla vita umana, o al suo deperimento. La seconda legge definisce il fine pratico del Robot: esso è un mezzo dell’uomo. Però è molto interessante osservare che non venga specificato da chi debbano provenire gli ordini, sebbene è implicito che sia da qualche uomo (ciò dovrebbe essere specificato, però. Infatti, si può dare il caso che il Robot si autordini). In fine, la terza legge osserva il Robot ha “diritto” alla vita e alla difesa a patto che non contravvenga alla prima e alla seconda legge: vale a dire che se c’è un attentatore e il Robot può salvare la vita al suo padrone al solo costo della propria esistenza, egli deve sacrificarsi senza esitazione.

Le leggi della Robotica non sono di genere logico né matematico. Non sono di genere logico perché hanno un chiaro contenuto prammatico, sebbene sia di ordine normativo. Però, esse non sono vere a priori e mostrano un certo significato concreto. Non sono di genere matematico perché non sono dedotte da alcun principio di natura numerica. In che senso, allora, le leggi della Robotica sono leggi. Possono essere leggi morali, leggi politiche, leggi fisiche. Senza dubbio non sono leggi fisiche perché non descrivono il comportamento di corpi né lo rendono prevedibile. Tuttavia, è a questo genere di legge che Asimov pensa: spiegheremo tra poco perché ciò sia lecito. Non è certamente un tipo di legge politica, nel senso che non è stata presa da una comunità come regola da seguire. Si tratta, in realtà, di “leggi morali” cioè delle norme che definiscono i comportamenti adeguati da quelli inadeguati. Questo livello è insufficiente. Perché il vincolo delle tre leggi non può essere esclusivamente di genere morale: il Robot deve essere vincolato in modo più forte che solo per delle convenzioni ad alto livello, cioè deve essere programmato in modo tale che sia incapace di pensare in modo diverso.

Prendiamo il caso dell’attentatore: se il Robot potesse pensare a lungo sul valore delle norme, allora avrebbe qualche esitazione sul proprio sacrificio, sentendo dentro di sé l’istinto della sopravvivenza (emozione[5] che deve sentire necessariamente per la terza legge). Dunque, il Robot è vincolato a due livelli alle leggi della Robotica: esso è programmato in senso fisico a pensare ed agire secondo le tre leggi della Robotica; in secondo luogo, egli ne è vincolato anche in senso morale, cioè riconosce quelle regole come corrette per la presa di decisioni. Questo punto è da rimarcare perché i Robot di Asimov pensano e sono in grado di operare scelte e queste devono essere sempre prese a partire da una giustificazione “legalistica”. Penso al romanzo “I robot e l’impero” in cui Daneel e Giskard alla fine diventano quasi dei “giuristi”.

Il problema delle tre leggi della Robotica è che esse falliscono nel concreto, in casi ben specifici: prendiamo il caso di un uomo che stia per sparare ad un altro con un fucile, abbastanza lontano da non esser raggiunto dall’androide, il duello tra Clint Eastwood e Volontè in “Per un pugno di dollari”. Cioè, entrambi gli uomini si minacciano reciprocamente. Il Robot non avrebbe il modo di salvare entrambe le vite. Questo caso rappresenta una doppia violazione della prima legge.

Altra possibilità è il caso dell’asino di Buridano: due bambine stanno affogando in una piscina. Egli è l’unico sorvegliante e le due ragazzine sono troppo lontane per essere salvate contemporaneamente. Come fare a scegliere? Non avendo una norma chiara in questo caso, il Robot potrebbe correre il rischio di non salvare nessuna delle due ragazze.

Un altro caso può essere rappresentato dal fatto che un Robot non può salvare qualcuno alle spese di qualcun altro, ad esempio, un attentatore può far saltare un intero palazzo e il Robot può salvare la vita di tutti solo con l’uccisione dell’uomo.

Tutti questi casi contrastano con la prima legge, se ne possono costruire molti altri anche con le altre. Le “morali” astratte hanno questo problema: non dicono come bisogna agire in casi concreti, esse possono essere molto utili, ma nascono problemi insanabili nei casi di conflitto.

L’ultimo caso è preso in considerazione da Asimov perché ne “I robot e l’impero” la storia porta i personaggi alla scoperta di un mostruoso progetto per distruggere la Terra da parte degli spaziali e i due protagonisti, due androidi, devono evitare la disgrazia. Sanno entrambi che dovranno procedere, ma questo costerà la trasgressione della prima legge perché è impossibile salvare la terra senza uccidere o danneggiare qualche essere umano. Dopo attente riflessioni, raggiungono la conclusione che debba esistere una “legge 0”: “C’è una legge superiore alla Prima Legge, e questa legge afferma che: Un robot non può fare del male all’umanità o, tramite l’inazione, permettere che un essere umano riceva danno, a meno che questo non contrasti con la Legge Zero.”[6] Questa legge cerca di compensare al problema chiaro posto dal caso specifico, che non è poi così raro: salvare due vite anziché una (aiutare tre persone anziché sedici).

Abbiamo esaurito il problema delle tre leggi dellaRobotica (anche se ora sono diventate cinque), nel modo in cui è stato elaborato da Asimov. Sebbene si possano nutrire seri dubbi sul fatto che esse possano essere il fondamento del comportamento dei Robot, cioè che possano utilmente vincolarlo, sono delle regole valide per gli uomini.

“Opera in modo che la massima della tua volontà possa sempre valere in ogni tempo come principio di una legislazione universale”[7] e “[N]on può mai esser tenuto per legge pratica un precetto pratico, che implichi una condizione materiale”[8]. Queste sono due celebri frasi della “Critica della ragion pratica” di Kant. Il pensatore tedesco ci sta mostrando come possiamo giungere alla determinazione di azioni conformi con il “bene collettivo”, le azioni, che sono il frutto di una decisione, possono essere prese o a partire da una legge universale o a partire da delle massime pratiche.

Le massime pratiche hanno la forma delle implicazioni logiche, se questo allora quello e ci mostrano come raggiungere degli scopi materiali particolari. Tuttavia, essendo questi scopi soggettivi, è facile che essi non siano indirizzati verso il bene collettivo. Così, per trovare una buona luce nella morale, ovvero qualcosa che non sia determinato dalla voglia del singolo, bisogna rivolgerci direttamente alla fonte di ogni legge particolare.

L’imperativo categorico non determina i singoli mezzi attraverso cui noi giungiamo ad un fine determinato, ma a cosa dobbiamo mirare. Questa legge non può essere contaminata da alcun che di particolare e soggettivo, altrimenti ricadremmo nella volontà singola e particolare. Dobbiamo invece porci dal punto di vista delle nostre categorie generali, giacché esse sono intersoggettive. Seguendo la nostra ragion pura pratica, saremmo certamente in grado di determinare chiaramente una legge in grado di condurci verso il bene collettivo[9]. Siamo al di fuori del soggettivismo perché questa legge è definita formalmente, dunque, non a partire da condizioni materiali. E’, in ciò, l’esatto opposto che la massima pratica, nata dal concreto per rifinire nel concreto. L’imperativo categorico nasce dalla ragione e si “concretizza” solo in un secondo momento. Tuttavia questo è il limite, secondo Kant, della legge morale: in un certo momento, essa deve “materializzarsi”.

La visione kantiana della morale e quella di Asimov, presentata nelle “cinque” leggi della Robotica, sono molto simili giacché entrambe sono di natura “formale”: i Robot come i soggetti morali ideali kantiani prendono le mosse da teoremi formalmente definiti e procedono per deduzioni. Entrambe le posizioni muovono dall’assunzione di una razionalità astratta, dove il dato concreto viene dopo la determinazione dell’azione moralmente più universale. In effetti, Kant si pone il problema di come sia una legge morale, cioè una norma del comportamento grazie alla quale possiamo derivare altre regole altrettanto universali, altrettanto fondate e intersoggettive. Asimov l’intersoggettività la rende possibile grazie alle leggi della Robotica e le deduzioni devono seguire necessariamente da esse.

E’ curioso che entrambe le posizioni si scontrino con problemi analoghi: il fatto concreto, la natura non-razionale dei soggetti (Asimov, nonostante l’assunzione che i Robot non abbiano alcuna emozione, concede possibilità limite in cui gli Androidi hanno reazione simili agli umani quando non hanno sufficienti cognizioni per agire), il tempo materiale in cui bisogna prendere le decisioni e i contesti d’azione.

[1] Asimov I., Abissi d’acciaio, Mondadori, Milano, 1988, Dall’introduzione di Lippi, p. 8.

[2] Asimov I., Abissi d’acciaio, Ivi., pp. 7-8.

[3] Per avere un riferimento non filosofico, si prenda “L’invasione degli ultracorpi” di D. Siegel.

[4] Quanto questa posizione possa essere irrazionale è testimoniato dal fatto che Hitler non era un Robot né lo sono i serial Killer. Nel caso di Hitler, inoltre, è assai difficile osservare che egli non concepisse emozioni, quando è risaputo che aveva dei gusti tutti personali in fatto di arte. Che fossero personali, d’accordo, ma è difficile avere dei gusti senza particolari emozioni! Inoltre, mi risulta che i peggiori scempi della storia, ad esempio la tratta degli schiavi proibita solo piuttosto di recente e antica come il mondo, non fosse fatta da androidi. In fine, non si vede per quale ragione un clone dovrebbe essere diverso da me nel modo di percepire il mondo: se egli è identico a me nel progetto di base, è evidente che debba anche sentire le mie stesse emozioni. In ciò non si solleva nemmeno l’obiezione dell’ipotetica possibilità di insensibilità (zombie di Chalmers), perché essa si può solo assumere in linea di principio per individui astratti. Il clone è un uomo a tutti gli effetti.

[5] Emozione e non ragionamento giacché nella ragione non si trova nulla che implichi la nostra fine.

[6] Asimov I., I robot e l’impero., Ivi., p. 294.

[7] Kant I., Critica della ragion pratica, Laterza, Roma-Bari, 2004, p. 65.

[8] Kant I., Critica della ragion pratica, Ivi., p. 73.

[9] In realtà l’analisi kantiana è assai più complessa, ma qui ci accontentiamo di questo.

[…] Di Pili G., http://www.scuolafilosofica.com “[L]e tre leggi della Golemica (…): 1) un golem non può nuocere all’uomo né permettere che, per il suo mancato intervento, un uomo riceva danno; 2) un golem deve sempre obbedire agli ordini ricevuti, a meno che questi non contrastino con la Prima… […]

il problema kantiano non risolto e surrettiziamente o inconsapevolmente taciuto e successivamente assimilato dal pensiero collettivo consiste nella contemporanea individuazione di uomo come soggetto etico, fine e non mezzo eppure ente sovraindividuale, astratto e mezzo al servizio di un fine assoluto. Inevitabilmente la sintesi appena espressa richiederebbe un ben piu’ ampio argomentare ma, alla luce dell’articolo a cui si riferisce, credo possa essere adeguatamente compresa. il geniale pensatore tedesco ci induce ad ipotizzare un essere umano che, seguendo le leggi universali della ragione, realizzerebbe il paradiso in terra, ipotesi non lontana da alcune teorie roboetiche attuali, ma non va dimenticata la collocazione della sua filosofia all’interno del pensiero razionalista dominante all’epoca delle sue Critiche. L’essere umano e’ tale nel momento in cui si assume la responsabilita’ e, contestualmente, il diritto alla stessa divenendo legislatore libero sin dalla legge “O” che, altrimenti, si chiuderebbe il cerchio ricollocando l’uomo a livello di androide o, peggio, nelle mani dell’ Ente trascendentale al quale attribuire senso e ragione del tutto.

L’articolo, scritto circa sette-otto anni fa, effettivamente proponeva un’interpretazione della legge morale kantiana in modo che a Kant sicuramente non sarebbe piaciuto. E’ vero che per Kant la legge morale ha un contenuto e non è solo vuota forma. Molti critici successivi hanno sottolineato l’elemento di vacuità proprio perché, a mio parere, avevano difficoltà a trovare controesempi e problemi. Detto questo, l’articolo aveva l’interesse di unire ambiti diversi per stimolare la fantasia e il pensiero del lettore!